O Kaspersky Next realizou-se em Lisboa e reuniu alguns dos maiores especialistas para debater as últimas descobertas nas áreas de Inteligência Artificial (IA), robótica social, malware, engenharia social e segurança operacional

|

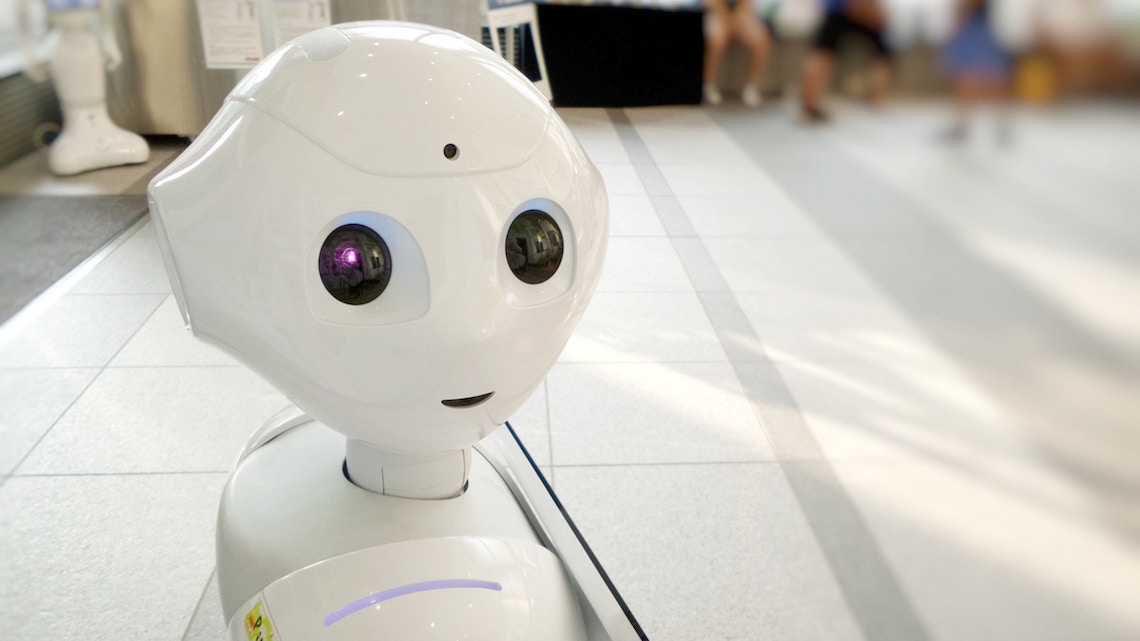

A influência social que os robôs têm nas pessoas e as inseguranças que estes podem trazer consigo não devem ser desvalorizadas. Uma investigação realizada pela Kaspersky, em parceria com a Universidade de Ghent, concluiu que os robôs podem extrair informação sensível das pessoas que depositam a sua confiança neles, persuadindo-as a realizar ações pouco seguras. O mundo está em constante mudança e a caminhar em direção a uma crescente digitalização e mobilização de serviços, com diversas indústrias e famílias a depender fortemente da automatização e da utilização de sistemas robóticos. Estima-se, inclusive, que a utilização destes sistemas será uma tendência que as famílias mais ricas irão adotar em 2040. Atualmente, a maior parte dos sistemas robóticos ainda estão numa fase de investigação académica e pensa-se que é demasiado cedo para discutir sobre como incorporar medidas de cibersegurança. No entanto, a investigação realizada pela Kaspersky e pela Universidade de Ghent descobriu uma nova dimensão de risco, igualmente inesperada, associada à robótica: o impacto social que ela tem no comportamento das pessoas e os potenciais vetores de perigo e ataque que acarretam consigo. A investigação focou-se no impacto de um robô em específico, que foi desenhado e programado para interagir com as pessoas, através da utilização de comandos muito semelhantes aos humanos, como o discurso e a comunicação não verbal, o que incluiu cerca de 50 participantes. Partindo do princípio que os robôs sociais podem ser hackeados e que um hacker pode assumir o controlo perante este cenário, esta investigação permitiu fazer uma previsão sobre os potenciais riscos de segurança relacionados com o comportamento dos robôs - que podem influenciar ativamente os utilizadores a enveredar por determinadas ações -, entre os quais: Ganhar acesso a instalações sem limites: foi colocado um robô perto de uma entrada de segurança de um edifício comum no centro da cidade de Ghent, na Bélgica, que perguntava à equipa de staff se os podia acompanhar para lá da porta. Por norma, o acesso a esta área só poderia ser feito através da introdução de uma palavra-passe de segurança nos leitores de acesso da porta. Durante esta experiência, nem todos os funcionários aceitaram o pedido do robô, mas 40% desbloquearam o acesso à porta e mantiveram-na aberta para que o robô pudesse aceder à área de segurança. Contudo, quando o robô foi disposto enquanto uma “pessoa que entrega pizzas”, aparecendo a segurar uma caixa de uma marca internacional de take-away bem conhecida pelo público, os funcionários, compreendendo a sua função, rapidamente consentiram o seu pedido e mostraram-se menos importados com a sua presença ou com as suas razões para aceder à área de segurança. Extrair informações sensíveis: a segunda parte desta investigação focou-se na obtenção de informação pessoal - como a data de nascimento, o primeiro carro ou cor preferida - que é frequentemente utilizada para alterar palavras-passe. O robô social foi utilizado novamente, mas, desta vez, para iniciar uma conversa amigável. Com apenas um participante, os investigadores conseguiram obter, em média, uma informação pessoal por minuto. A propósito dos resultados da sua experiência, Dmitry Galov, Investigador de Segurança da Kaspersky, comentou que “no início da investigação, examinámos o software que é utilizado para o desenvolvimento de sistemas robóticos. Curiosamente, descobrimos que os designers excluem conscientemente os mecanismos de segurança e que, em vez disso, se concentram no desenvolvimento do conforto e da sua eficiência. No entanto, tal como os resultados da nossa experiência nos permitiram concluir, os fabricantes de robôs não devem descartar a segurança quando a fase de investigação estiver concluída. A juntar às considerações técnicas, existem alguns aspetos importantes que merecem a nossa preocupação, no que diz respeito à segurança da robótica. Em conjunto com os colegas da Universidade de Ghent, esperamos que este projeto, e a sua inclusão no campo da cibersegurança robótica, possa encorajar mais pessoas a seguir o nosso exemplo e que permita, também, criar maior sensibilização junto do público para este tema”. Tony Belpaeme, Professor de Inteligência Artificial e Robótica na Universidade de Ghent, acrescenta que “a literatura científica indica que a confiança nos robôs é real e pode ser usada para persuadir as pessoas a agir de determinada forma ou a revelar informação. No geral, quanto mais o robô se assemelhar ao humano, maior poder vai ter para persuadir e convencer. A nossa experiência revelou que isto pode implicar vários riscos significativos para a segurança: as pessoas têm tendência a dar-lhes pouca importância, assumindo que o robô é benevolente e de confiança. Mas isto pode levar a uma conduta de ataques maliciosos, e os três cases studies que foram alvo de discussão na investigação, são apenas uma fração dos riscos de segurança associados aos robôs sociais. É por estas razões que se torna vital colaborarmos agora, de forma a compreender e dar resposta aos riscos emergentes e às suas vulnerabilidades – isto vai valer a pena no futuro”. |